COPU会议纪要丨2024.11.26

COPU开源联盟 2024年11月26日 13:29 北京

11月26日,陆主席主持召开COPU例会。

本次会议介绍由顶级AI公司 Deep Mind开发的一种所谓超出人类设计水平的自动进行芯片AI设计布局的方法 Alphachip。

由于全文篇幅较长、专业性较强,本次会议主要作出有关说明,介绍英伟达CEO黄仁勋的介绍,并对全文的引言部分、设计领域自适应策略部分和结论部分进行介绍;全文将在不久出版的 COPU《人工智能汇集》二十一集上转载,以嚮诸位。

一种用于快速芯片设计图形布局方法

(A graph placement methodology for fast-chip design)

作者:Anne Goldie, AZalie MirhoSeini等,Deep Mind(公司)

北京大学荆琦团队译自《Nature》Vol.594, 2021.6.10

COPU转载前说明:

这是由 Deep Mind开发的自动进行芯片设计布局的一种强化学习方法 Alphachip。

2020年由DeepMind开发,2021年在《Nature》上发表,2024年命名为 Alphachip。

Alphachip是首批被应用于解决实际工程问题的强化学习方法,其发布引发了芯片设计领域人工智能应用的爆炸性增长。

据英伟达CEO黄仁勋介绍 Alphachip的使用范围为:

①用于完成自动芯片设计(实现芯片设计全流程自动化),②通过互搏,可产生人类还没有的棋类数据,③可用于自动进行算力优化,④可用于自动训练大模型,自动生成合成数据,⑤可在通用人工智能(AGI)研发成功后加速完成超级人工智能(ASI)的总体设计布局,⑥用于进行科研。

黄仁勋并介绍 Alphachip目前使用的若干案例:谷歌已用于设计TPU,DeepMind致力于AI的自我进化,联发科已用于加速芯片开发(优化总片性能、能耗、面积),等。

下面转载该论文的引言、设计领域的自适应策略和结论三部分:

引言

我们的方法在不到6小时内就能生成可制造的芯片平面图,相比之下,最强的基线方法需要人类专家数月的紧张努力。

计算机芯片分为几十个块,每个块都是一个单独的模块,例如内存子系统、计算单元或控制逻辑系统。这些块可以用网表来描述,网表是电路组件的超图,例如宏(内存组件)和标准单元(逻辑门,如 NAND、NOR 和 XOR),所有这些都由导线连接。芯片布局规划涉及将网表布局在芯片画布(二维网格)上,以便优化性能指标(例如功耗、时序、面积和线长),同时遵守对密度和路由拥塞的硬约束。

为了解决芯片平面规划问题,我们开发了一种能够跨芯片泛化的RL方法——这意味着它可以从经验中学习,变得更好、更快地布局。

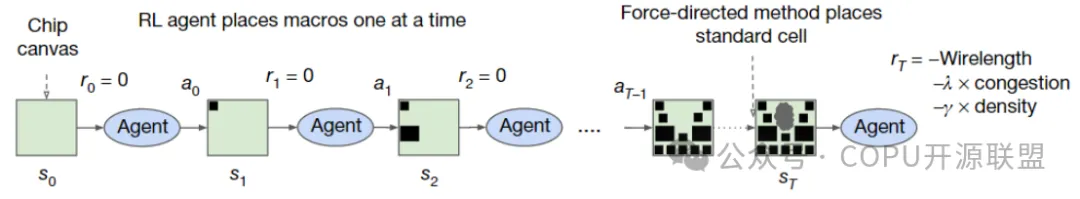

图 1 |我们的方法和训练方案概述。在每个训练迭代中,RL 代理一次布局一个宏(动作、状态和报酬分别用 ai、si 和 ri 表示)。一旦布局所有宏,标准单元就会使用力定向方法布局。中间报酬为零。每次迭代结束时的报酬计算为近似线长、拥塞和密度的线性组合,并作为代理的反馈,以优化下一次迭代的参数。

在这项工作中,我们提出了一种新的基于强化学习的图布局方法,并展示了在芯片平面规划这一长期挑战性问题上的最新成果,这个问题长期以来一直难以实现自动化,尽管已经进行了五十年的研究。与需要人类专家数月紧张工作的强大基线相比,我们的方法能够在不到6小时内生成可制造的芯片平面图。

为了解决芯片平面规划问题,我们开发了一种能够跨芯片泛化的RL方法——这意味着它可以从经验中学习,变得越来越好和更快地布局新的芯片——-允许芯片设计人员由经验大于任何人类的人工代理辅助。

训练能够跨芯片泛化的布局策略极具挑战性,因为这需要学习优化所有可能的芯片网表到所有可能的画布上。芯片平面规划类似于一个游戏,其中有变化的部分(例如,网表拓扑、宏单元计数、宏单元大小和长宽比)、棋盘(变化的画布大小和长宽比)和获胜条件(不同评估指标的相对重要性或不同的密度和路由拥堵约束)。即使是这个游戏的一个实例(将特定的网表布局在特定的画布上)也有一个巨大的状态-动作空间。例如,在有1000个单元的网格上布局1000个节点簇的状态空间是1000的阶乘(大于10^2500),而围棋的状态空间是10^360(引用)。

为了实现泛化,我们专注于学习芯片的可迁移表示,将表示学习建立在预测布局质量的监督任务中。通过设计能够准确预测各种网表及其布局报酬的神经架构,我们能够生成输入网表的丰富特征嵌入。然后,我们使用这种架构作为策略和价值网络的编码器来实现迁移学习。在我们的实验中,我们表明,由于我们的代理暴露在更大的芯片体积和各种芯片中,为新的芯片块生成优化布局既更快又更好,这使我们更接近芯片设计者由具有巨大芯片布局经验的人工代理辅助的未来。

除了对芯片平面规划的直接影响外,我们方法的泛化能力和快速生成高质量解决方案的能力具有重大意义,它解锁了与芯片设计过程的早期阶段共同优化的机会。以前,由于需要数月的人力工作来准确评估给定的架构候选,大规模的架构探索是不可能的。然而,修改架构设计可以对性能产生巨大的影响,并将促进芯片设计过程的完全自动化。自动化和加速芯片设计过程还可以实现人工智能和硬件的共同设计,产生为重要工作负载定制的高性能芯片,如自动驾驶汽车、医疗设备和数据中心。

在抽象层面上,我们的方法学会了在一定约束下,将超图的节点映射到有限的资源集上。这种形式的布局优化出现在广泛的科学和工程应用中,包括硬件设计、城市规划、疫苗测试和分发以及大脑皮层布局。因此,我们相信我们的布局优化方法可以应用于超出芯片设计的有影响力的布局问题。

设计领域自适应策略

为芯片平面规划问题开发领域自适应策略极具挑战性,为了应对这一挑战,我们首先专注于学习状态空间的丰富表示。我们的直觉是,能够胜任芯片布局这一通用任务的策略也应该能够在推理时将与新未见芯片相关的状态编码成有意义的信号。因此,我们训练了一个神经网络架构,能够预测新网络列表布局的报酬,最终目标是使用该架构作为我们策略的编码器层。

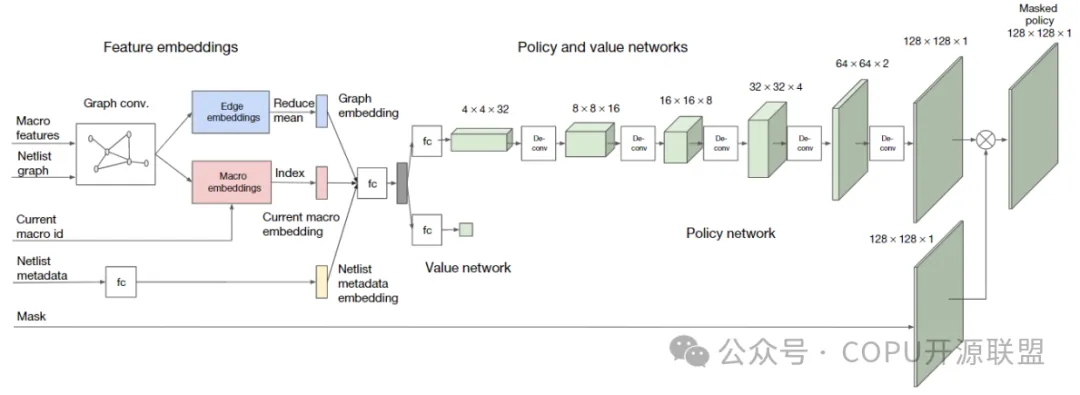

图2 策略与价值网络架构。嵌入层对有关网表邻接关系、节点特征和当前要布局的宏单元进行编码。然后,该网络分别输出可用网格单元的概率分布和对当前位置的预期报酬的估计。

为了训练这个监督模型,我们需要一个大的芯片布局数据集和相应的报酬标签。因此,我们创建了一个包含10,000个芯片布局的数据集,其中输入是与给定布局相关的状态,标签是该布局的报酬。

为了准确预测报酬标签并推广到未知数据,我们开发了一种基于边缘的图神经网络架构,我们称之为Edge-GNN(基于边的图神经网络)。该网络的作用是嵌入网表,将节点的类型和连通性信息提炼成可用于下游任务的低维向量表示。我们基于边的神经结构一般性的作用如扩展数据图2所示。

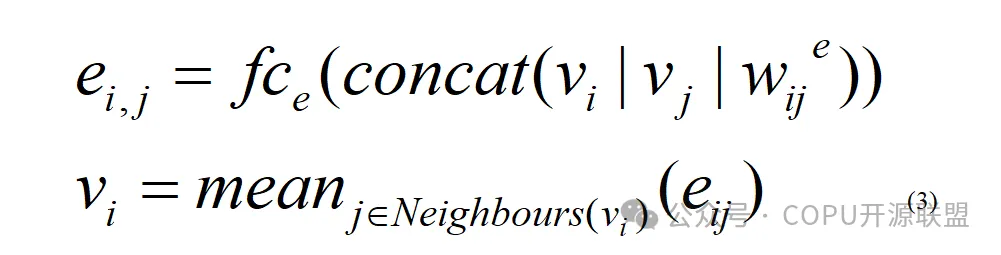

在Edge-GNN中,我们通过连接每个节点的特征(包括节点类型、宽度、高度、x和y坐标以及与其他节点的连通性)来创建每个节点的初始表示。然后,我们迭代地执行以下更新:(1) 每条边通过将全连接网络应用于它所连接的两个节点的串联来更新其表示,以及 (2) 每个节点通过将所有进出边的平均值传递给另一个全连接网络来更新其表示。节点和边缘更新如式(3)所示。

当1≤i≤N时,节点嵌入用vi表示,其中N为宏和标准单元簇的总数。连接节点vi和vj的边的向量表示记为eij。fce表示完全连接层,对应边eij(连接节点i和j)的可学习权值。算法的输出是节点嵌入和边嵌入。

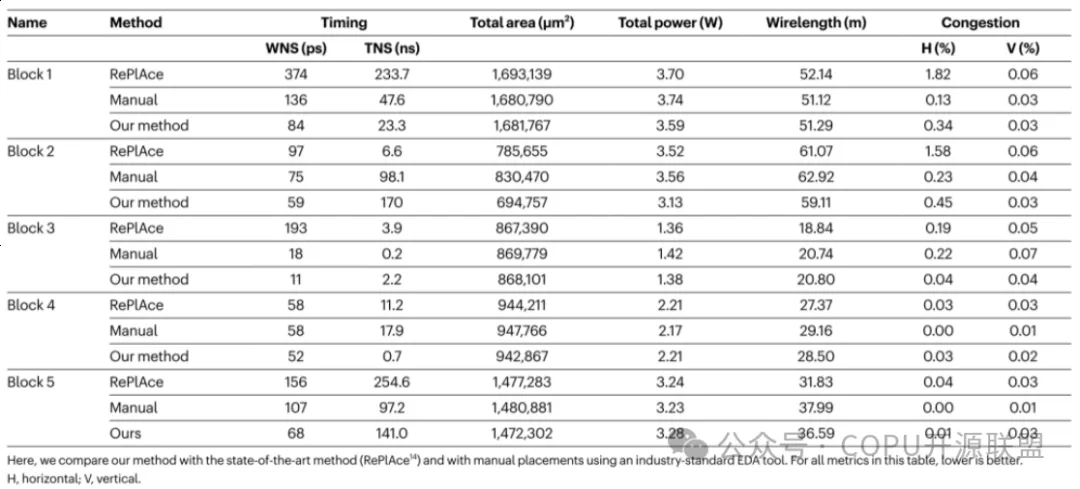

表 1 |与基线的比较

在这里,我们将我们的方法与最先进的方法 (RePlAce14) 和使用行业标准 EDA 工具手动布局进行比较。对于该表中的所有指标,越低越好。H,水平;V,垂直。

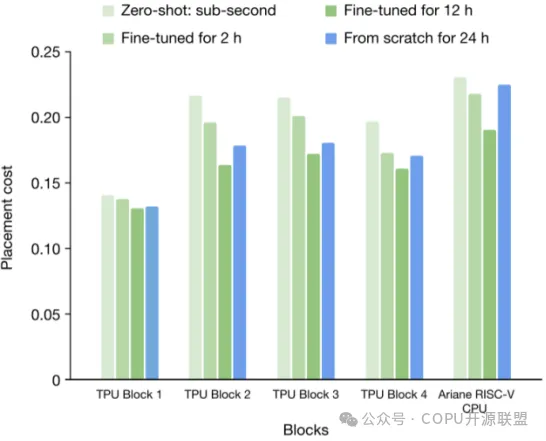

图3 从头开始训练与不同时间量的微调的比较。对于每个块,我们显示了基于zero-shot,2小时和12小时微调后的结果,以及从头开始训练策略的结果。从表中可以看出,预训练的策略网络的性能始终优于从头开始训练的策略网络,这证明了离线从训练数据中学习的有效性。

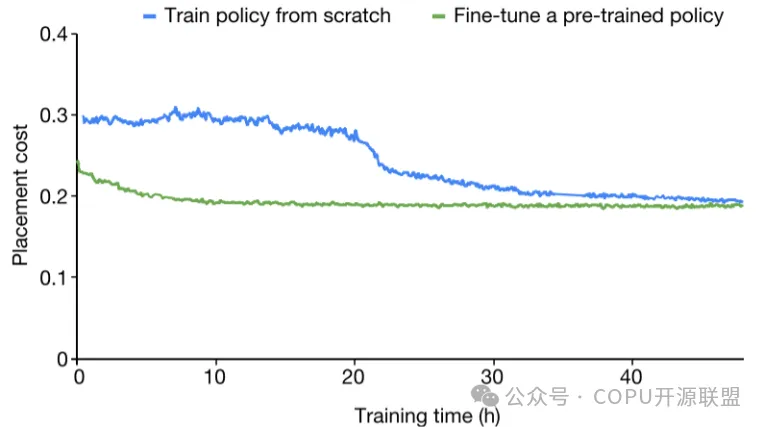

图4 Ariane RISC-V CPU上的收敛图。从头开始训练策略网络与为一块Ariane RISC-V CPU微调预训练策略网络的布局成本的比较。密度权重设为0.1,拥塞权重设为0。

监督模型通过回归训练来最小化加权均方损失(负报酬)。这一监督任务使我们能够找到在不同网表中泛化报酬预测所需的特征和架构。为了将Edge-GNN集成到我们的RL策略网络中,我们移除了预测层,然后将其用作策略网络的编码器,如图2所示。

在推理时布局新的网表时,我们会加载策略网络的预训练权重并应用于新的网表。我们将使用预训练策略且未经过微调生成的布局称为零样本布局。这样的布局可以在亚秒级时间内生成,因为每个宏仅需要通过预训练策略进行一次前向传递。我们可以通过微调策略网络进一步优化布局质量。这样做可以让我们灵活地选择使用预训练的权重(这些权重已经学习到了输入状态的丰富表示)或进一步微调这些权重以针对特定芯片网表的属性进行优化。

图1展示了所提出的策略网络(由等式(1)中的πθ建模)和价值网络架构的概览。输入包括网表超图(表示为邻接矩阵和节点特征列表)、当前要布局的节点的身份、网表的元数据以及工艺技术节点(例如,7纳米)。网表被送入我们的Edge-GNN架构以生成部分布局网表和当前节点的嵌入。我们使用前馈网络对元数据进行嵌入。这些嵌入向量随后被连接起来形成状态嵌入,该状态嵌入被传递给另一个前馈神经网络以生成状态的最终表示。这个状态接着被送入策略网络(由五个反卷积、批标准化和修正线性单元(ReLU)激活层组成)以生成动作的概率分布,并被送入价值网络(由前馈网络组成)以预测输入状态的价值。反卷积层具有3×3的内核大小、2的步幅以及16、8、4、2和1个滤波器通道。

结论

在这项工作中,我们提出了一种基于强化学习(RL)的芯片布局方法,该方法能够进行领域适应。随着布局更多的芯片网表,RL代理变得更加高效且更快速地优化布局。我们展示了我们的方法能够在不到六小时的时间内生成与人类专家相当或更优的芯片布局,而人类通常需要几个月的时间才能为现代加速器生成可接受的布局。我们的方法已在生产中用于设计下一代Google TPU。

再谈算力竞争

陆首群 2024.11.25

本文主要取材于IDC (2023)对国内外的统计数字,今归纳成文如下:

一、建设算力中心

在人工智能时代,依靠算力中心的创新计算能力,对于推动人工智能加速发展是必不可少的。算力中心的规模效应很重要,正在从千卡、万卡向十万卡、百万卡发展,当然大规模算力中心的建设也跟巨额投资、巨大能耗的制约因素有关,国内发展多为千卡、万卡(百度升级AI异构计算平台百舸4.0为10万卡集群),国外已建成10万卡,正在规划百万卡。

Open AI曾设想,在开发GPT-5之后计划建设Sora集成训练服务中心,集成7000多张H100算力卡,总算力约7×10⁶TFLOPS,需要电力400MW。

OpenAI与英伟达曾设想,在开发GPT-6之后计划建设“星际之门”集成训练服务中心,集成10万张H100算力卡,总算力约10⁸TFLOPS,需要电力5000 MW。

2024年8月,埃隆·马斯克(Elon Musk)宣布建成10万张H100算力卡的机房,成为标配。

2024年10月,英伟达CEO黄仁勋宣布,将利用星链卫星建设空中超大型数据服务中心(10万张卡,可能采用B200芯片集成,总算力约为2×10⁸TFLOPS,2024年底将发射第一颗星链卫星,该算力中心提供大型Token数据和算力服务。

大规模超算中心的发展,已超越目前用于简单的预训练模型的功能,正在发展为涵盖后训练、多模态、合成数据生成和高级推理能力的功能。

超算中心以提供集成的智能算力为核心,而智能算力的基础是 AI芯片。

二、英伟达的产品系列(列出FP16单片芯片算力)

英伟达(NVIDIA)从一个制作图形服务器、营业额约6000亿美元的中等企业一跃而成为市值飙升为3.5万亿美元全球最大的芯片公司,在500强企业中先后超越苹果、微软,达到全球市值第一,称霸GPU算力领域。

英伟达在售或即将发售的GPU产品系列为:

A100,H100,H200,GH200,B100,B200,FullB200,GB200。

其中, Ampere:A100(3.12×102TF)为早期产品,H100(10³TF)为目前的旗舰产品,Hopper:H200(10³TF)为当前一代仍受欢迎的旗舰产品,GH200(103TF),B100(1.75×103TF),Blackwell:为超级芯片系统,B200(2.25×103TF)、FullB200(2.5×103TF),今年即将交货的旗舰产品,GB200(2.5×10³TF)。

三、IDC(2023)报道国内AI芯片市场销售量

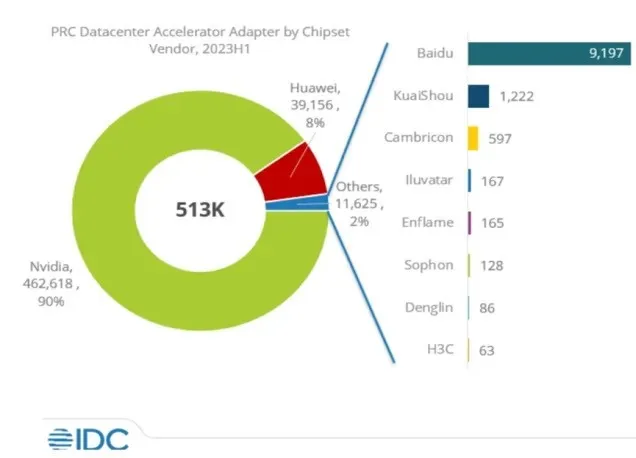

英伟达(NVIDIA): 90%, 华为(Huawei):8%, 其他(other):2%

图片来源:公众号·IT技术分享-老张

四、2024年算力市场新情况

今年收集到有关算力发展的一些新情况,兹认为如下:

1) 美国政府加强对华打压,目前英伟达(NVIDIA)连打折的算力芯片也实行断供。

2)华为自主开发7nm昇腾910C芯片(为910b升级版)其算力对标英伟达的H200 (103TFOPS/FP16)同时成本要低得多)(原来生产的910b对标英伟达的。A100/3.12×10²TF)

3)11月25日中国商务部会见英伟达。商务部副部长王受文在京会见英伟达公司全球副总裁普瑞,考虑到英伟达在人工智能以及芯片领域拥有一定的话语权,寻求进一步发展提升算力,而中国拥有全球最大的消费市场,双方就合作进行讨论。

4)马斯克、黄仁勋谈:建设大型算力中心需要巨额投资几千亿美元~几万亿美元(以至需要几百万亿美元),一般企业(包括头部企业)很难负担;而且能耗巨大,马斯克认为世上只有中国才能承担,美国还行,但美国尚需国外能源支持(如找加拿大合作等)。

参会人员:陆首群、陈伟、章文嵩、陈道清、张侃、安泱、谭中意、朱其罡、荆琦、鞠东颖、陈钟(线上)、韩宪平(线上)、隆云滔(线上)。